I 1970-årene dukket det opp noe vi kalte mini- eller lommekalkulator, et teknisk hjelpemiddel som raskt ble populært. På den tiden gikk jeg i barneskolen. Jeg lærte for eksempel hvordan jeg manuelt skulle gå fram for å finne svaret på hva 732 x 128 var.

Jeg var ganske flink, men det tok selvsagt litt tid. Kalkulatoren ordnet det imidlertid på et par sekunder, hvis vi altså fikk lov til å bruke den.

Jeg husker bare vagt diskusjonene om kalkulatorens plass i matematikkundervisningen den gang. I første omgang var det, slik jeg husker det, ikke anledning til å bruke kalkulator til hjelp i matematikk i barneskolen, mens det langt tidligere ble anledning til dette i ungdomsskolen og på videregående. Jeg antar planen var at barn skulle lære grunnleggende regneferdigheter før de fikk anledning til å ta teknologien i bruk. Enkelte var utvilsomt bekymret for om barns regneferdigheter ville bli dårligere som følge av kalkulatorens inntog. Andre mente sikkert den var nyttig fordi matematikkundervisningen nå kunne orienteres mot forståelse.

Spenningen mellom disse synspunktene minner sterkt om dagens debatt om kunstig intelligens (KI). Jeg skal her rette oppmerksomheten mot den form for KI som kalles språkmodeller. Så vidt jeg forstår, kan språkmodeller både formulere setninger, og evaluere noe man har skrevet og foreslå forbedringer. Man kan be KI om å skrive et essay om Henrik Ibsen, man kan be modellen strukturere en tekst man har skrevet bedre enn man selv har fått til, eller man kan føre en slags dialog med KI om hva som er viktig å ha med i et slikt essay.

Jeg gjentar: Så vidt jeg forstår. Jeg har nemlig aldri brukt KI. Jeg er en gammel mann, så prøv å bære over med meg. Jeg registrerer at man nå kan velge «AI mode» når man gjør et søk i google, men jeg har aldri forsøkt selv. Hvorfor skulle jeg det? Jeg tror vi har noe på jobben som heter co-pilot, men jeg skjønner hverken hva det er, hvordan jeg skal bruke det eller hva det mon kunne være nyttig for. Kort sagt: Hvis jeg vil skrive et essay om Henrik Ibsen, finner jeg kilder både i digitale ressurser og i bøker og artikler jeg har tilgjengelig på papir. Så formulerer jeg noe som forhåpentligvis peker på noe nytt; et resonnement eller et argument som er mitt, fordi det er jeg som har formulert det. Jeg forsikrer meg dessuten så godt jeg kan om at kildene jeg bruker er forfattet av mennesker.

Selv jeg innser jo at det ikke finnes noen vei tilbake, like lite som det var noe håp for den manuelle skrivemaskinen da til og med jeg lærte meg å formulere tekstene mine på PC. Som med alle teknologiske revolusjoner, er spørsmålet hvorvidt de positive konsekvensene mer enn oppveier de negative. Om det ikke er tilfelle, betyr imidlertid ikke det at man kan fjerne teknologien. Enkelte ønsker seg nok tilbake til tiden før smarttelefonen også, men det vil – forsiktig sagt – neppe skje.

Det er altså en ganske tydelig parallell mellom debatten om kalkulatoren og debatten om KI. Det er imidlertid en viktig forskjell: Å bruke KI til å uttrykke seg språklig er noe annet enn å bruke det til å utføre regneoperasjoner. Språk inneholder nyanser, tvetydighet, ironi, sarkasme og personlig syntaks. Å overlate dette til en språkmodell øver vold mot alt dette.

Så langt har mye av debatten om språkmodeller i akademia handlet om eksamenssituasjoner. Mange har gått over fra hjemme- til skoleeksamen for å forhindre at KI skriver oppgaver på studentens vegne. På den andre siden har vi de som tvert imot mener at eksistensen av KI gjør skoleeksamener enda mindre relevante enn de allerede var.

Til den siste gruppen hører for eksempel Tor W. Andreassen, som mener den akademiske debatten om KI må handle om helt andre ting enn plagiatkontroll og eksamensformer. Han mener også mer effektive litteratursøk kan gjøre forskningen mer effektiv. (Som om problemet i dag er at det publiseres for få artikler.) Magnus Nordmo mener KI kan hjelpe oss å skrive bedre, samtidig som det gjør læring til en mer aktiv prosess. Frode Eika Sandnes og Yngve Røe mener – satt på spissen – at hvis et emne eller et studium ikke kan evalueres på fornuftig vis med hjemmeeksamen, kan studiet like gjerne legges ned. En del studenter mener på sin side at Chat GPT gir dem bedre læringseffekt enn lærebøker, og i forlengelsen av dette blir det argumentert for at også norske fagbøker bør integreres i KI-verktøy.

Jeg kunne selvsagt forlenget denne listen over eksempler på fagfolk som mener det faktum at KI eksisterer, gjør at det må integreres i alle prosesser hvor det kan gjøre den minste nytte, inkludert i eksamenssituasjoner. Rett nok er det mye som tyder på at virksomheter som har investert i KI så langt mener de har fått lite igjen for det, men det kan jo endre seg på sikt.

De skeptiske vil for eksempel peke på at KI knapt vil forbedre hverken folks lese- eller skriveferdigheter, to områder hvor evnene opplagt er blitt drastisk forverret de siste årene. Rett nok har jeg inntrykk av at KI har bidratt til mindre helt ubehjelpelig språk i studentoppgaver, men på den annen side er det også mer vagt og intetsigende. Mer alvorlig blir det når KI for eksempel brukes til å gi råd om helse, når det viser seg at disse er tvilsomme og av og til også farlige. Eller når språkmodeller er bygget på et ønske om å gi brukerne et bestemt inntrykk av hvordan virkeligheten er skrudd sammen. Elon Musks Grok er for eksempel nærmest designet for å forsyne brukerne med feilaktig informasjon.

Overfor slik kritikk kan man selvsagt gå inn for å bygge opp mer troverdige språkmodeller, for eksempel i Norge. Dessuten kan man, som Inga Strümke, peke på den store forskjellen mellom KI generelt og språkmodeller mer spesielt. Strümke peker for eksempel på et bildegjenkjenningsprogram som drastisk effektiviserte vurderingen av røntgenbilder. Det er nyttig. Men det er noe helt annet enn en språmodell.

En språkmodell sier ingenting om virkeligheten. Den er trent til å lage gode og tilforlatelige setninger, ikke til å si noe om den verden språket presumptivt skulle refererer til. Den vet jo ingenting om denne verden.

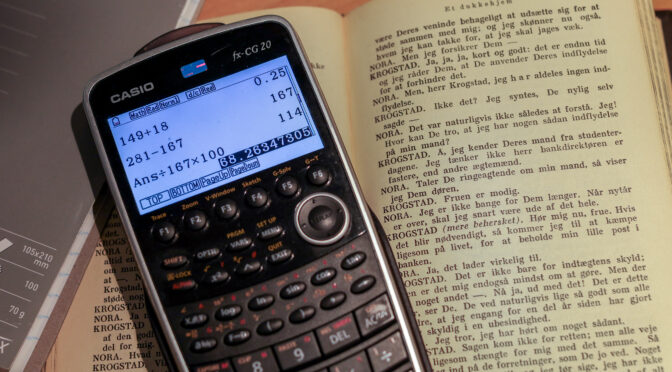

Det er derfor er en fundamental forskjell på en lommekalkulator og en språkmodell. Lommekalkulatoren er programmert slik at den uten nøling finner det riktige svaret selv på komplekse regnestykker. Det skyldes at matematikk er et system av aksiomer som til sammen danner et logisk system. Det finnes dermed en fasit, gitt at vi godtar forutsetningene systemet bygger på. Kalkulatoren har ingen bevissthet og kan dermed ikke regne, men den kan programmeres til å gi oss et riktig svar dersom vi mater den med den informasjonen vi ønsker.

Det er ikke tilfelle med språkmodeller. Språket er ikke et logisk og entydig system. Det bygger på nyanser. Litteratur kan være bevisst tvetydig. Når en forsker tolker data, må det tas stilling til om et funn skal betraktes som svært overraskende eller bare som overraskende (eller hvorfor ikke som forventet)? I slike tilfeller forkludrer språkmodeller mer enn de oppklarer.

Denne innsikten har også praktiske konsekvenser. I kjølvannet av Malthe-Sørensen-utvalget er det for eksempel diskutert hvorvidt man kan bruke KI til å vurdere eksamensbesvarelser. Ved Oslomet er det blitt brukt en lukket KI-modell i den hensikt å undersøke dette. Konklusjonen ser ut til å være at KI-støtte kan være nyttig dersom man utformer vurderingsgrunnlaget på en svært detaljert og nyansert måte. Det er spesielt utfordrende i fag og emner som krever refleksjon og drøfting, og mindre utfordrende dersom studentene bare skal gjengi det de har lært.

Vurderingskriterier er naturligvis uomgjengelige. Spørsmålet er likevel hvor presist de kan eller bør formuleres. Jeg har ofte vært sensor på emner hvor sensorveiledningen har vært til liten nytte, enten fordi forventningene til studentenes kunnskaps- og refleksjonsnivå har vært altfor høye eller altfor lave, eller fordi det viser seg at oppgaven er blitt tolket litt annerledes enn faglærer kanskje hadde tenkt. Én ting er at det dermed kan være nødvendig å nyansere vurderingskritieriene underveis. Mer interessant er at det neppe er mulig å se for seg at det er mulig å skrive dem ut på forhånd på en måte som KI kunne ha nytte av. I praksis bruker sensorer ofte en form for taus kunnskap når de vurderer besvarelser, har Vidar Gynnild påpekt. Denne kunnskapen må tas i bruk også om man lar en språkmodell vurdere oppgaven først. Kvalitetssikringen av språkmodellens vurdering vil trolig ta minst like mye tid som å lese selve oppgaven.

Jeg vil ikke svare for andre fag, men i mine fag har jeg drevet med vurdering i over 30 år. Det er helt utenkelig å sette bort noen form for sensur til ikke-menneskelig teknologi, hvis man da ikke går for det (i mitt tilfelle) helt uegnede multiple choice-formatet.

Det er kanskje ikke noen grunn til å fortvile over at studenter ikke uten videre kan multiplisere sammen tresifrede tall, men det er noe helt annet å overlate språket til maskiner. Når jeg skriver dette, er det en form for tenkning. Det er sikkert en mangelfull form for tenkning, men det er like fullt tenkning.

Jeg leter etter formuleringer, justerer ordstillinger og tar stilling til hvilket ord som best beskriver hva jeg vil ha fram. Jeg kan gjøre dårlige vurderinger, men dette er min tekst. Det er ikke aktuelt å abdisere til fordel for en maskin.

–> Arve Hjelseth, Knut Peder Heen og Hans Petter Iversen skriver fast i Panorama.